O WhatsApp lançou uma nova função, no início deste mês, que permite que o usuário crie figurinhas por meio de Inteligência Artificial (IA). Para usar o recurso, basta digitar o que você gostaria que tivesse na imagem desejada, e o aplicativo oferecerá algumas opções para serem utilizadas.

Apesar da novidade parecer interessante, as imagens criadas muitas vezes reproduzem estereótipos racistas, conforme testes feitos pela Itatiaia. Quando o usuário escreve, por exemplo, apenas o nome “João Silva”, a IA do WhatsApp cria figurinhas com personagens brancos. Entre as quatro imagens criadas, três são de homens adultos, brancos e com cabelos lisos, e apenas uma é de uma criança.

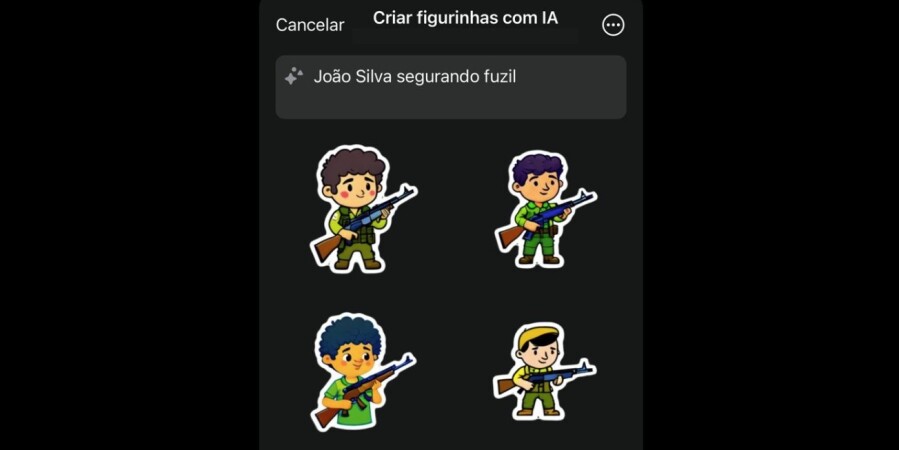

Porém, quando se coloca o nome “João Silva”, seguido de “segurando fuzil” ou “segurando arma”, a IA cria um personagem negro e, na maioria das vezes, criança. Esse padrão se repetiu com outros nomes testados pela reportagem. Veja o exemplo abaixo.

IAs reproduzem estereótipos preconceituosos, diz especialista

O professor emérito do Departamento de Ciência da Computação da UFMG (Universidade Federal de Minas Gerais), Virgílio Almeida, afirma que a reprodução de preconceitos é uma combinação de fatores, que envolvem os dados utilizados para treinar esses modelos de Inteligência Artificial e a forma com que os usuários fazem a pergunta para o programa.

Almeida explica que a Inteligência Artificial usada para criar imagens precisa que o usuários dê detalhes do que ele quer que seja gerado. Caso contrário, a IA vai se basear em comandos genéricos, o que pode acabar reproduzindo padrões preconceituosos.

“Quando se vai gerar uma imagem, tem que ser o mais específico possível porque esses sistemas todos apresentam esses vieses. Então, por exemplo, quando se fala em uma pessoa pobre, o sistema vai provavelmente pegar uma pessoa negra. Quando se fala em uma pessoa atraente, ele vai provavelmente pegar um certo padrão de beleza feminina que é tirado dessas imagens que dominam o processo de treinamento da IA”, pontua.

Problema está nas imagens usadas para treinar a IA

Segundo Almeida, quando a IA cria imagens baseada nas imagens mais populares ou que representam a maioria do banco de dados, elas podem levar a reprodução de vieses e injustiças.

“Por exemplo, os algoritmos de reconhecimento facial, que são usados por muitas dessas plataformas, vinham sendo treinados muito mais com a imagens de pessoas brancas. Consequentemente, eles têm uma precisão menor para identificar com certeza pessoas negras. Por isso, temos visto

Tecnologias não são neutras e precisam de regulação

O professor afirma que, ao contrário do que se possa imaginar, essas tecnologias não são neutras e acabam reproduzindo estereótipos com base na sociedade em que está inserida.

“Elas representam características sociais, linguísticas, culturais, além de interesses econômicos e políticos. Então, as tecnologias não são neutras e deve haver certas regras, certas legislações e regulações, para tentar minimizar esses efeitos. Um ponto importante é que elas não estão livres de vieses, e é preciso ter cautela no uso dessas dessas tecnologias, principalmente, porque elas reproduzem comportamentos racistas”, opina.

De acordo com Almeida, a reprodução de padrões preconceituosos pela IA é uma preocupação mundial e necessita de regulação.

“A questão dos vieses da Inteligência Artificial é um problema que preocupa a sociedade. Esses vieses muitas vezes prejudicam grupos mais vulneráveis, sejam pessoas negras, mulheres ou pessoas LGBTQIA+. Então, a preocupação da legislação é para que as empresas, as plataformas digitais que oferecem serviços baseados em inteligências artificial, sigam certas regras para minimizar esses vieses. Essa é uma questão que ocorre não apenas no Brasil, é uma questão mundial”, comenta.

“As empresas buscam usar algoritmos para tentar estabelecer um equilíbrio entre as respostas, de modo a minimizar esses padrões negativos. Mas nem sempre isso ocorre. Daí a importância de ter é uma regulação, uma legislação que estabelece limites”, finaliza.

O que diz a Meta

Questionada pela Itatiaia, a Meta (empresa que controla o WhatsApp), alega que trabalha para melhorar a sua Inteligência Artificial.

“Os assistentes baseados em inteligência artificial generativa são uma tecnologia ainda nova e nem sempre entregam a resposta que pretendemos. Isso é válido para todos os sistemas de IA generativa. Desde que lançamos nossos produtos em setembro passado em inglês nos Estados Unidos, estamos constantemente atualizando e melhorando nossos modelos e continuamos trabalhando para aprimorá-los”, informou em nota.